信息论

Deep Learning Math

Deep Learning Math

信息论(Information Theory)

信息论在深度学习中至关重要。信息量和熵度量数据的不确定性和信息量。相对熵(Kullback-Leibler 散度)和交叉熵用于衡量概率分布的差异,交叉熵常用于分类任务中的损失函数。互信息则用于度量两个变量间的共享信息量,帮助理解变量依赖性,常用于特征选择。

Jensen 不等式、Chebyshev 不等式和 Pinsker 不等式在信息论中用于估计和界定概率分布的性质。通过这些工具,深度学习能够优化模型性能,提升预测准确性。

Agenda

Agenda

-

信息量和熵

- 信息量的定义

- 熵的定义与性质

- 联合熵与条件熵

- 相对熵(Kullback-Leibler 散度)

- 交叉熵

-

互信息

- 互信息的定义

- 互信息的性质

- 互信息的应用

-

不等式

- Jensen 不等式

- Chebyshev 不等式

- Pinsker 不等式

Additional Packages for Google Colab

Additional Packages for Google Colab

If you are using Google Colab, you have to install additional packages. To do this, simply run the following cell.

信息量与熵(Information and Entropy)

信息量与熵(Information and Entropy)

信息量的定义

信息量的定义

当一个事件发生时,我们会经历从不知道该事件是否会发生到知道它已经发生的变化。在这一过程中,我们的认知不确定性减少了,这种不确定性减少的量即为信息量。信息量越大,表示该事件发生所带来的不确定性减少越多。通常,信息量用比特(bit)来表示。

对于某一个离散事件 $x$ ,其信息量 $I(x)$ 可以定义为:

$$

I(x)=-\log _b P(x)

$$

其中:

- $P(x)$ 是事件 $x$ 发生的概率。

- $b$ 是对数的底,可以取不同的值:

- 当 $b=2$ 时,信息量的单位是比特 (bits)。

- 当 $b=e$ 时,信息量的单位是纳特(nats),其中 $e \approx 2.71828$ 是自然对数的底。

比特是计算机科学中的基本单位。一个比特的信息量表示一个二进制位 ( 0 或 1) 的信息。在选择对数的底为 2 的情况下,如果一个事件的发生概率 $P(x)$ 为 0.5 ,那么其信息量为:

$$

I(x)=-\log _2(0.5)=-(-1)=1 \text { bit }

$$

纳特是信息量的自然单位,在底数取自然对数 $e$ 时使用。例如,如果一个事件的发生概率 $P(x)$ 为 0.5 ,那么其信息量为:

$$

I(x)=-\log _e(0.5) \approx 0.693 \text { nats }

$$

信息量表示当事件 $x$ 发生时,我们对该事件发生的确定性增加了多少。不确定性越大(即事件越不常见),其信息量越大。

熵的定义

熵的定义

熵(Entropy)是信息论中的一个基本概念,用来衡量一个随机变量的不确定性。熵的概念最早由克劳德·香农(Claude Shannon)在其开创性的论文《通信的数学理论》(A Mathematical Theory of Communication)中提出。熵在信息论、统计学、热力学等领域有广泛的应用和深远的影响。

熵的定义:

对于一个离散随机变量 $X$ 及其概率分布 $P(X)$ ,摘 $H(X)$ 定义为:

$$

H(X)=-\sum_{x \in X} P(x) \log _b P(x)

$$

其中:

- $P(x)$ 是随机变量 $X$ 取值 $x$ 的概率。

- $b$ 是对数的底,可以取不同的值:

- 当 $b=2$ 时,摘的单位是比特 (bits)。

- 当 $b=e$ 时,摘的单位是纳特 (nats)。

熵表示在长时间观察该随机变量时,我们每次观测所获得的信息量的平均值。它反映了一个随机变量的不确定性程度。

信息量和熵的基本联系在于它们都是基于事件发生概率 $P(x)$ 的对数计算的度量。信息量衡量单个事件带来的不确定性减少,而熵是所有可能事件的信息量的加权平均值。

熵可以看作是信息量的期望值。对于一个随机变量 $X$ ,熵 $H(X)$ 是其可能取值的信息量 $I(x)$ 的期望, 即:

$$

H(X)=\mathbb{E}[I(X)]=\sum_{x \in X} P(x) I(x)

$$

这意味着熵是每个事件的信息量乘以其发生概率的总和。通过这种方式,熵衡量了一个随机变量的整体不确定性,而不是单个事件的信息量。

熵的性质:

-

- 非负性

摘总是非负的,即 $H(X) \geq 0$ 。这是因为概率 $P(x)$ 总是大于 0 且小于等于 1 ,因而对数值 $\log _b P(x)$ 总是小于等于 0 。由于熵是这些值的加权和的负值,所以摘总是非负的。

-

- 确定性

如果随机变量 $X$ 是确定的(即其概率分布为某一个特定值的概率为 1 ,其他为 0 ),则䐱 $H(X)=0$ 。这是因为在这种情况下,不确定性完全消除,没有信息需要传递。例如,假设我们有一个确定的事件,其概率 $P(x)=1$ ,则:

$$

H(X)=-\left[1 \log _b 1\right]=0

$$

-

- 最大值

对于一个有 $n$ 个可能值且每个值概率均等的离散随机变量 $X$ ,摘达到最大值 $\log _b n$ 。例如,假设我们有一个均匀分布的随机变量 $X$ ,其每个可能值的概率均为 $\frac{1}{n}$ ,则摘计算如下:

$$

H(X)=-\sum_{i=1}^n \frac{1}{n} \log _b \frac{1}{n}=\log _b n

$$

在这种情况下,由于每个可能值的概率均等,不确定性达到最大,因此摘也达到最大值。

总的来说,熵是衡量一个随机变量不确定性的度量,是信息论中的核心概念。通过定义和性质的理解,我们可以更好地掌握信息熵的本质,并在数据分析、通信、编码、机器学习等领域中应用这一概念来优化信息处理和传输的效率。熵的非负性、确定性和最大值性质使其在各种场景下都有重要的理论和实际意义。

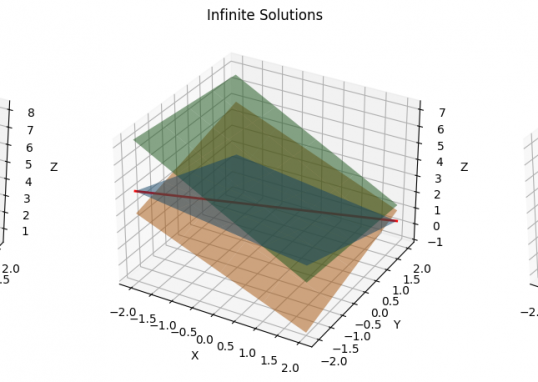

联合熵

联合熵 $H(X, Y)$ 衡量两个随机变量 $X$ 和 $Y$ 的联合不确定性,它扩展了单个随机变量的熵的概念,通过考虑两个变量的联合概率分布来评估系统的整体不确定性。定义为:

$$

H(X, Y)=-\sum_{x \in X} \sum_{y \in Y} P(x, y) \log _b P(x, y)

$$

其中:

- $P(x, y)$ 是 $X$ 和 $Y$ 的联合概率分布,表示 $X$ 取值为 $x$ 且 $Y$ 取值为 $y$ 的联合概率。

- $b$ 是对数的底,可以取 2 (单位为比特,bits) 或 $e$ (单位为纳特, nats)。

联合摘衡量的是在同时观察两个随机变量 $X$ 和 $Y$ 时系统的不确定性。它考虑了这两个变量之间的关系和相互依赖性,因此比单个变量的摘提供了更多的信息。

情况一: 独立随机变量

如果 $X$ 和 $Y$ 是独立的随机变量,那么它们的联合概率分布可以表示为单变量概率分布的乘积,即 $P(x, y)=P(x) P(y)$ 。在这种情况下,联合熵 $H(X, Y)$ 可以分解为两个单变量熵的和:

$$

H(X, Y)=H(X)+H(Y)

$$

这意味着,如果两个随机变量彼此独立,它们的联合不确定性等于各自不确定性的总和。

情况二: 相关随机变量

如果 $X$ 和 $Y$ 是相关的随机变量,它们的联合概率分布 $P(x, y)$ 不能简单地分解为单变量概率的乘积。在这种情况下,联合熵 $H(X, Y)$ 不等于单变量熵的和,而是考虑了两个变量之间的相互关系。

换句话说,在这种情况下,我们需要使用联合概率分布来直接计算联合熵 $H(X, Y)$ 。这是一个包含所有可能的 $(x,y)$ 组合及其对应概率的分布表。

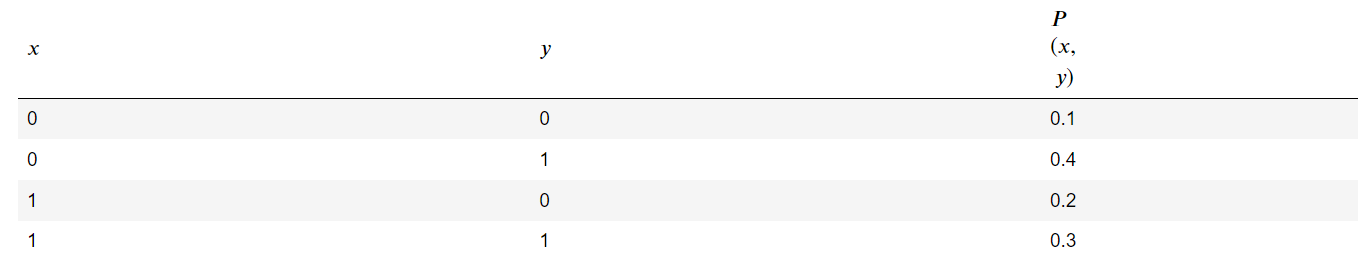

假设我们有两个相关的随机变量 $X$ 和 $Y$ ,它们的联合概率分布如下表所示:

我们选择对数的底 $b=2$ ,则联合摘 $H(X, Y)$ 计算如下:

-

计算每个 $(x, y)$ 组合的贡献:

- 对于 $(0,0)$ :

$$

P(0,0) \log _2 P(0,0)=0.1 \log _2 0.1 \approx 0.1 \cdot(-3.32)=-0.332

$$ - 对于 $(0,1)$ :

$$

P(0,1) \log _2 P(0,1)=0.4 \log _2 0.4 \approx 0.4 \cdot(-1.32)=-0.528

$$ - 对于 $(1,0)$ :

$$

P(1,0) \log _2 P(1,0)=0.2 \log _2 0.2 \approx 0.2 \cdot(-2.32)=-0.464

$$ - 对于 $(1,1)$ :

$$

P(1,1) \log _2 P(1,1)=0.3 \log _2 0.3 \approx 0.3 \cdot(-1.737)=-0.5211

$$

- 对于 $(0,0)$ :

-

累加所有组合的贡献:

$$

H(X, Y)=-(-0.332-0.528-0.464-0.5211) \approx 1.8451 \text { bits }

$$

条件熵

条件熵 $H(Y \mid X)$ 用来衡量在已知随机变量 $X$ 的情况下,随机变量 $Y$ 的剩余不确定性。通过条件熵,我们可以更深入地理解两个随机变量之间的相互关系及其依赖性。

条件熵 $H(Y \mid X)$ 定义为:

$$

H(Y \mid X)=-\sum_{x \in X} \sum_{y \in Y} P(x, y) \log _b P(y \mid x)

$$

其中:

- $P(x, y)$ 是 $X$ 和 $Y$ 的联合概率分布,表示 $X$ 取值为 $x$ 且 $Y$ 取值为 $y$ 的联合概率。

- $P(y \mid x)$ 是在已知 $X=x$ 的条件下, $Y$ 取值为 $y$ 的条件概率分布。

- $b$ 是对数的底,可以取 2 (单位为比特,bits) 或 $e$ (单位为纳特,nats)。

条件熵 $H(Y \mid X)$ 表示在已知 $X$ 的情况下, $Y$ 的不确定性。它衡量的是我们在知道 $X$ 之后,对 $Y$ 还需要了解多少信息。

举个:

假设我们有两个随机变量 $X$ 和 $Y$ ,例如天气状况 $X$ (晴天、雨天) 和上班交通工具选择 $Y$ (开车、坐公交)。在这种情况下,条件熵 $H(Y \mid X)$ 可以帮助我们理解在知道天气状兄的情况下,对交通工具选择的剩余不确定性。例如,如果在晴天和雨天的情况下,人们选择交通工具的行为有显著差异,那么条件熵会较低,表明天气状况对交通工具选择有很好的预测性。

条件熵的性质

- 链式法则

条件熵的一个重要性质是链式法则,它描述了联合熵、单变量熵和条件熵之间的关系:

$$

H(X, Y)=H(X)+H(Y \mid X)

$$

这意味着联合熵 $H(X, Y)$ 可以分解为 $X$ 的熵 $H(X)$ 和在已知 $X$ 的情况下 $Y$ 的条件熵 $H(Y \mid$ $X)$ 。这条法则表明了信息的传递过程,其中 $H(X)$ 是关于 $X$ 的信息,而 $H(Y \mid X)$ 是在知道 $X$后需要额外获取的关于 $Y$ 的信息。

- 非负性

条件熵具有非负性,即 $H(Y \mid X) \geq 0$ 。这是因为条件熵表示的是不确定性的剩余量,不可能为负。若 $H(Y \mid X)=0$ ,则说明在已知 $X$ 的情况下, $Y$ 完全确定,没有不确定性。

相对熵(Kullback-Leibler 散度,简称 KL 散度)

相对熵用于衡量两个概率分布 $P, Q$ 之间的差异。它通过计算两个分布之间的信息差异来评估一个分布在多大程度上偏离了另一个分布。

对于离散概率分布 $P$ 和 $Q, \mathrm{KL}$ 散度定义为:

$$

D_{K L}(P | Q)=\sum_{x \in X} P(x) \log _b \frac{P(x)}{Q(x)}

$$

其中:

- $P(x)$ 是事件 $x$ 在分布 $P$ 下的概率。

- $Q(x)$ 是事件 $x$ 在分布 $Q$ 下的概率。

- $b$ 是对数的底,可以取 2 (单位为比特,bits) 或 $e$ (单位为纳特,nats)。

KL 散度度量的是使用分布 $Q$ 来近似分布 $P$ 时所引入的信息损失。它反映了在使用 $Q$ 代替 $P$ 的过程中,我们需要额外了解的信息量。

KL 散度的性质

- 非负性

KL 散度具有非负性,即:

$$

D_{K L}(P | Q) \geq 0

$$

且只有当 $P=Q$ 时, KL 散度才等于零。这意味着两个分布完全相同时,它们之间的差异为零; 而当两个分布不同时时,KL 散度始终为正值。

- 非对称性

KL 散度是非对称的,即:

$$

D_{K L}(P | Q) \neq D_{K L}(Q | P)

$$

这意味着从 $P$ 到 $Q$ 的散度与从 $Q$ 到 $P$ 的散度是不同的。因此,KL 散度不能用来衡量两个分布之间的对称差异,而是更适合衡量一个分布相对于另一个分布的偏差。

相对熵(KL 散度)用于衡量两个概率分布之间的差异,是一个重要的工具。它具有非负性和非对称性,能够量化使用一个分布来近似另一个分布时的信息损失。KL 散度在机器学习中的应用广泛,特别是在变分自动编码器和强化学习中,起到了关键的作用。通过理解和应用KL 散度,我们可以更好地优化模型,提高算法的性能。

JS散度

Jensen-Shannon 散度(Jensen-Shannon Divergence, JSD)是对称的散度度量,基于 KL 散度。它用于衡量两个概率分布的相似性,定义为:

$$

J S D(P | Q)=\frac{1}{2} D_{K L}(P | M)+\frac{1}{2} D_{K L}(Q | M)

$$

其中 $M=\frac{1}{2}(P+Q)$.

JSD 的性质:

$\mathrm{JSD}$ 的性质:

- 对称性: $J S D(P | Q)=J S D(Q | P)$ 。

- 范围: $0 \leq J S D(P | Q) \leq 1$ , JSD 值越小表示两个分布越相似。

- 平滑性: 由于 JS散度通过中间分布 $M$ 引入平滑,常用于概率分布的比较,尤其是在生成对抗网络 (GAN) 中用作评价指标。

总变差散度

总变差散度(Total Variation Divergence)是另一个衡量两个概率分布之间差异的度量。定义为:

$$

D_{T V}(P, Q)=\frac{1}{2} \sum_{x \in X}|P(x)-Q(x)|

$$

总变差散度的性质:

- 对称性: $D_{T V}(P, Q)=D_{T V}(Q, P)$ 。

- 范围: $0 \leq D_{T V}(P, Q) \leq 1$ ,总变差散度越小表示两个分布越相似。

- 直观性:总变分散度具有直观的几何解释,通过计算两个概率分布在每个可能值上的绝对差,然后取总和的一半。计算较为简单

Hellinger散度

Hellinger 距离是一种基于几何视角的散度度量,用于衡量两个概率分布之间的差异。定义为:

$$

H(P, Q)=\frac{1}{\sqrt{2}}\left(\sum_{x \in X}(\sqrt{P(x)}-\sqrt{Q(x)})^2\right)^{\frac{1}{2}}

$$

Hellinger 距离的性质:

- 对称性: $H(P, Q)=H(Q, P)$ 。

- 范围: $0 \leq H(P, Q) \leq 1$, Hellinger 距离越小表示两个分布越相似。

- 平滑性:Hellinger 散度通过计算概率分布的平方根,然后求欧几里得距离。计算比总变分散度稍复杂,但比 JS散度更直观。

交叉熵

交叉熵(Cross-Entropy)是信息论中用于衡量两个概率分布 𝑃 和 𝑄 之间相似性的度量。它通过计算使用分布 𝑄 来表示分布 𝑃 时所需要的额外信息量来评估两个分布的差异。交叉熵广泛应用于机器学习,特别是在分类问题中用于衡量模型预测的准确性。

对于离散概率分布 $P$ 和 $Q$ ,交叉熵 $H(P, Q)$ 定义为:

$$

H(P, Q)=-\sum_{x \in X} P(x) \log _b Q(x)

$$

其中:

- $P(x)$ 是事件 $x$ 在真实分布 $P$ 下的概率。

- $Q(x)$ 是事件 $x$ 在估计分布 $Q$ 下的概率。

- $b$ 是对数的底,可以取 2 (单位为比特,bits) 或 $e$ (单位为纳特,nats)。

交叉熵衡量的是在使用估计分布 $Q$ 表示真实分布 $P$ 时所需要的平均额外信息量。如果 $P$ 和 $Q$ 越相似,交叉熵值就越小; 如果 $P$ 和 $Q$ 差异越大,交叉熵值就越大。

交叉熵的性质

- 与熵的关系

交叉熵 $H(P, Q)$ 可以分解为熵 $H(P)$ 和 KL 散度 $D{K L}(P | Q)$ 之和:

$$

H(P, Q)=H(P)+D\{K L}(P | Q)

$$

其中:

- $H(P)$ 是真实分布 $P$ 的熵,表示 $P$ 的自身不确定性。

- $D_{K L}(P | Q)$ 是 KL 散度,表示使用 $Q$ 来近似 $P$ 所引入的额外不确定性。

这种关系揭示了交叉摘的两个组成部分: 一个是关于分布 $P$ 的固有不确定性,另一个是因为分布 $Q$与 $P$ 之间的不匹配所引入的额外不确定性。

- 特殊情况: 完美匹配

当两个分布 $P$ 和 $Q$ 完全相同时,交叉嫡 $H(P, Q)$ 等于摘 $H(P)$ ,此时 KL散度为零:

$$

H(P, Q)=H(P)

$$

这表明在这种情况下,使用 $Q$ 表示 $P$ 没有额外的信息损失。

- 可加性

对于多个独立事件的联合分布,交叉摘具有可加性。例如,对于两个独立事件 $\left(X_1, X_2\right)$ 和 $\left(Y_1, Y_2\right)$ ,其交叉摘为:

$$

H\left(P_1, P_2 ; Q_1, Q_2\right)=H\left(P_1, Q_1\right)+H\left(P_2, Q_2\right)

$$

这表明多个独立事件的联合分布的交叉摘等于各个独立事件交叉摘的总和。

交叉熵 $H(P, Q)$ 是衡量两个概率分布 $P$ 和 $Q$ 之间相似性的度量。在深度学习中,交叉熵损失函数被广泛用于分类问题,主要有以下几个原因:

-

概率解释:交叉熵可以很好地处理概率输出。在分类问题中,我们通常希望输出一个概率分布,而交叉熵损失直接衡量了预测概率分布与真实概率分布之间的差异。

-

对数损失:交叉熵包括对数函数,这会使得当模型预测接近于真实标签时,损失较低;而当预测错误较大时,损失会急剧增大。这种特性能够有效地惩罚错误预测,并有助于模型快速收敛。

互信息

互信息

互信息的定义

互信息 (Mutual Information, MI) 是信息论中的一个基本概念,用于衡量两个随机变量之间的相互依赖性。具体来说,互信息衡量的是知道一个变量的信息量对减少另一个变量的不确定性所做的贡献。对于两个离散随机变量 $X$ 和 $Y$ ,其互信息 $I(X ; Y)$ 定义为:

$$

I(X ; Y)=\sum_{x \in X} \sum_{y \in Y} P(x, y) \log \frac{P(x, y)}{P(x) P(y)}

$$

其中:

- $P(x, y)$ 是 $X$ 和 $Y$ 的联合概率分布。

- $P(x)$ 和 $P(y)$ 分别是 $X$ 和 $Y$ 的边缘概率分布。

互信息的性质

- 非负性: 互信息总是非负的,即 $I(X ; Y) \geq 0$ 。

- 对称性: 互信息是对称的,即 $I(X ; Y)=I(Y ; X)$ 。

- 互信息与摘的关系:

- 互信息可以表示为两个随机变量的摘的和减去它们的联合摘:

$$

I(X ; Y)=H(X)+H(Y)-H(X, Y)

$$ - 互信息也可以表示为熵减去条件熵:

$$

I(X ; Y)=H(X)-H(X \mid Y)=H(Y)-H(Y \mid X)

$$

互信息的应用

在机器学习中,互信息(Mutual Information, MI)最常见的应用是可以用于特征选择,帮助选择那些与目标变量具有较大相关性的特征。通过最大化特征和目标变量之间的互信息,我们可以筛选出对预测最有用的特征,从而提高模型的性能。

举个:

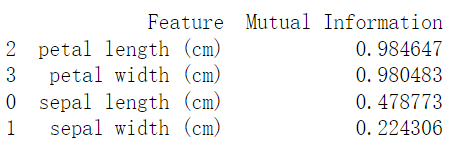

假设我们有茑尾花数据集,其中目标变量 $Y$ 表示总尾花的类别,特征变量 $X_1, X_2, X_3, X_4$ 分别表 $I\left(X_i ; Y\right)$ ,我们可以选择互信息值较大的特征。下面是如何在总尾花数据集中应用这一过程的具体示例:

from sklearn.datasets import load_iris

import pandas as pd

# 加载鸢尾花数据集

iris = load_iris()

X = pd.DataFrame(iris.data, columns=iris.feature_names)

y = pd.Series(iris.target, name='species')

from sklearn.feature_selection import mutual_info_classif

# 计算每个特征与目标变量之间的互信息

mi = mutual_info_classif(X, y)

# 将互信息结果与特征名称对应

mi_df = pd.DataFrame({'Feature': X.columns, 'Mutual Information': mi})

# 根据互信息值排序

mi_df = mi_df.sort_values(by='Mutual Information', ascending=False)

# 显示结果

print(mi_df)

从上表中可以看到,“花瓣长度”和“花瓣宽度”与目标变量(鸢尾花类别)的互信息值较大,这意味着它们对分类最有用。而“花萼长度”和“花萼宽度”的互信息值较小,对分类的贡献较小。

因此,通过选择互信息值较大的特征,我们可以筛选出对预测最有用的特征,从而提升模型的性能。在实际应用中,可以仅使用“花瓣长度”和“花瓣宽度”来训练分类模型,以提高模型的准确性和效率。

这个过程展示了如何利用互信息进行特征选择,从而在分类问题中提高模型性能。

不等式

不等式

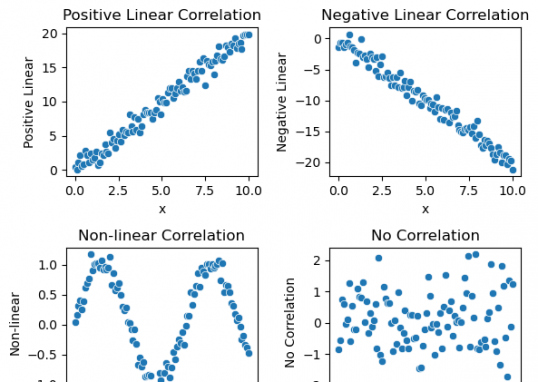

这些不等式在信息论中起着关键作用,提供了各种信息量度量之间的关系和界限。通过这些不等式,我们可以推导出许多重要的理论结果,并在实际应用中用于评估和优化信息处理和传输系统。这些不等式不仅在信息论中具有理论意义,而且在机器学习、统计学和数据科学等领域也有广泛的应用。以下是几种常见的数据图形化表示方式:

-

Jensen 不等式

-

Chebyshev 不等式

-

Pinsker 不等式

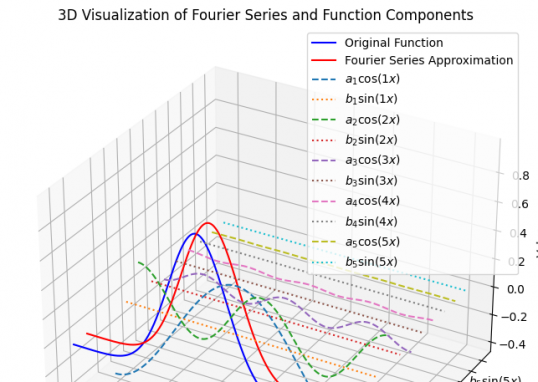

Jensen 不等式

Jensen 不等式是凸函数与期望值之间的重要关系,在信息论中有着广泛的应用。具体来说,如果 $\phi$是一个凸函数,并且 $X$ 是一个随机变量,那么 Jensen 不等式表明:

$$

\phi(\mathbb{E}[X]) \leq \mathbb{E}[\phi(X)]

$$

Jensen 不等式在信息论和概率论中有多种应用,其中的一个重要应用为变分推断。

在变分推断(Variational Inference, VI)中,Jensen 不等式用于推导证据下界(Evidence Lower Bound, ELBO),从而使我们能够以优化的方式进行近似推断。

变分推断的目标是近似计算后验分布 $P(Z \mid X)$ ,其中 $X$ 是观测数据, $Z$ 是潜在变量。直接计算后验分布通常是不可行的,因为它涉及复杂的积分。具体来说,这个积分的难点在于:

- 高维度:当参数 $\theta$ 是高维的时,积分的计算复杂度会急剧增加。

- 非闭形式: 大多数实际模型中,联合分布 $P(X, \theta)$ 没有解析解,无法直接计算积分。

因此,我们通过引入一个变分分布 $q(Z)$ 来近似 $p(Z \mid X)$ ,可以得到:

$$

\log p(X)=\log \int \frac{p(X, Z)}{q(Z)} q(Z) d Z

$$

应用 Jensen 不等式,我们得到:

$$

\log p(X) \geq \int q(Z) \log \frac{p(X, Z)}{q(Z)} d Z

$$

因为对数是凹函数,Jensen不等式给出了这个下界。现在我们将右边的表达式分解:

$$

\log p(X) \geq \int q(Z) \log \frac{p(X \mid Z) p(Z)}{q(Z)} d Z

$$

我们将积分分解为两个部分:

$$

\log p(X) \geq \int q(Z) \log p(X \mid Z) d Z+\int q(Z) \log \frac{p(Z)}{q(Z)} d Z

$$

第一个部分是重构误差的期望:

$$

\mathbb{E}_{q(Z)}[\log p(X \mid Z)]

$$

第二个部分是KL散度:

$$

-\mathrm{KL}(q(Z) | p(Z))

$$

因此,我们得到证据下界 (ELBO) 的最终表达式:

$$

\log p(X) \geq \mathbb{E}_{q(Z)}[\log p(X \mid Z)]-\operatorname{KL}(q(Z) | p(Z))

$$

证据下界 (ELBO) 表示为:

$$

\mathcal{L}=\mathbb{E}_{q(Z)}[\log p(X \mid Z)]-\operatorname{KL}(q(Z) | p(Z))

$$

这个ELBO的优化目标就是在给定数据 $X$ 的情况下,找到最优的变分分布 $q(Z)$ ,使得该下界最大化。最大化这个下界相当于最小化KL散度,使得 $q(Z)$ 更接近真实后验分布 $p(Z \mid X)$ 。这将在变分自编码器VAE中进行详细讲解。

Jensen不等式另一个重要应用为证明KL散度为大于0的正数:

具体来说,KL散度的定义是:

$$

K L(q | p)=\int q(z) \log \left(\frac{q(z)}{p(z)}\right) d z

$$

由于对数函数是一个凸函数,所以根据Jensen不等式,可以得到:

$$

\int q(z) \log \left(\frac{q(z)}{p(z)}\right) d z \geq \log \left(\int q(z) \frac{q(z)}{p(z)} d z\right)=\log (1)=0

$$

Chebyshev 不等式

Chebyshev用于量化随机变量偏离其均值的概率。该不等式指出,对于任何随机变量,无论其分布如何,只要知道它的均值和方差,就可以界定它偏离均值的概率上界。

公式定义

Chebyshev 不等式表明,对于任何随机变量 $X$ 以及任何正数 $k>0$ ,都有:

$$

P(|X-\mu| \geq k \sigma) \leq \frac{1}{k^2}

$$

其中:

- $\mu=\mathbb{E}[X]$ 是随机变量 $X$ 的期望 (均值)。

- $\sigma^2=\operatorname{Var}(X)$ 是随机变量 $X$ 的方差。

Chebyshev 不等式的直观解释是,它提供了一个保守的估计,说明随机变量 $X$ 偏离其均值 $\mu$ 超过 $k \sigma$ 的概率不会超过 $\frac{1}{k^2}$ 。换句话说,随机变量 $X$ 有至少 $1-\frac{1}{k^2}$ 的概率在均值 $\mu$ 的 $k \sigma$ 范围内。

举个例子:假设我们有一个随机变量 $X$ ,其期望 $\mu=50$ ,标准差 $\sigma=5$ 。我们希望估计 $X$ 偏离其均值超过 10 的概率,即 $k=2$ 时的情况。

根据 Chebyshev 不等式:

$$

P(|X-50| \geq 10) \leq \frac{1}{2^2}=\frac{1}{4}=0.25

$$

这意味着随机变量 $X$ 偏离其均值 50 超过 10 的概率不超过 0.25 (即 $25 \%$ )。

Pinsker 不等式

Pinsker 不等式在信息论和概率论中是一个重要的工具,用于量化两个概率分布之间的总变分散度(Total Variation Distance, TVD)和它们的相对熵(即 Kullback-Leibler 散度,KL 散度)之间的关系。

公式表示:

具体来说,Pinsker 不等式表明,对于任意两个概率分布 $P$ 和 $Q$ ,它们的总变差距离 $\delta(P, Q)$ 和 $\mathrm{KL}$ 散度$D_{\mathrm{KL}}(P | Q)$ 满足以下关系:

$$

\delta(P, Q) \leq \sqrt{\frac{1}{2} D_{\mathrm{KL}}(P | Q)}

$$

其中,总变差距离定义为:

$$

\delta(P, Q)=\frac{1}{2} \sum_x|P(x)-Q(x)|

$$

KL 散度定义为:

$$

D_{\mathrm{KL}}(P | Q)=\sum_x P(x) \log \frac{P(x)}{Q(x)}

$$

直观解释

Pinsker 不等式提供了一种手段,将两个概率分布之间的“距离”从信息理论的度量(KL 散度)转换为概率论的度量(总变分散度)。具体来说:

- KL 散度通过期望值衡量分布之间的差异,强调信息的角度。它通过对数函数的性质量化了使用一个分布替代另一个分布所带来的信息损失。

- 总变分散度直接衡量两个分布在每个可能结果上的差异,是一种更直观的比较方式,符合概率论中对分布差异的基本理解。

- Pinsker 不等式将信息论的度量(KL 散度)和概率论的度量(总变差距离)联系起来,表明如果两个分布的 KL 散度很小,那么它们的总变差距离也会很小。

Pinsker 不等式意味着,尽管 KL 散度和总变差距离度量的角度不同,但它们在衡量概率分布差异时是相关的。这为我们提供了从信息论角度(通过 KL 散度)估计概率论角度(通过总变分散度)差异的工具,反之亦然。

统计学

统计学

统计学旨在根据数据样本推测总情况。大部分统计分析都基于概率,所以这两方面的内容通常兼而有之。

Credits

Credits

- Icons made by Becris from www.flaticon.com

- Icons from Icons8.com - https://icons8.com

- Datasets from Kaggle - https://www.kaggle.com/

- Examples and code snippets were taken from "Hands-On Machine Learning with Scikit-Learn and TensorFlow"

- Tal Daniel

作者

arwin.yu.98@gmail.com